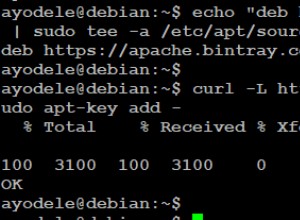

Solucioné este problema agregando el siguiente código

JavaSparkContext newcontext = new JavaSparkContext(session.sparkContext());

Map<String, String> readOverrides = new HashMap<String, String>();

readOverrides.put("collection", "details");

readOverrides.put("readPreference.name", "secondaryPreferred");

ReadConfig readConfig = ReadConfig.create(newcontext).withOptions(readOverrides);

MongoSpark.load(newcontext,readConfig);