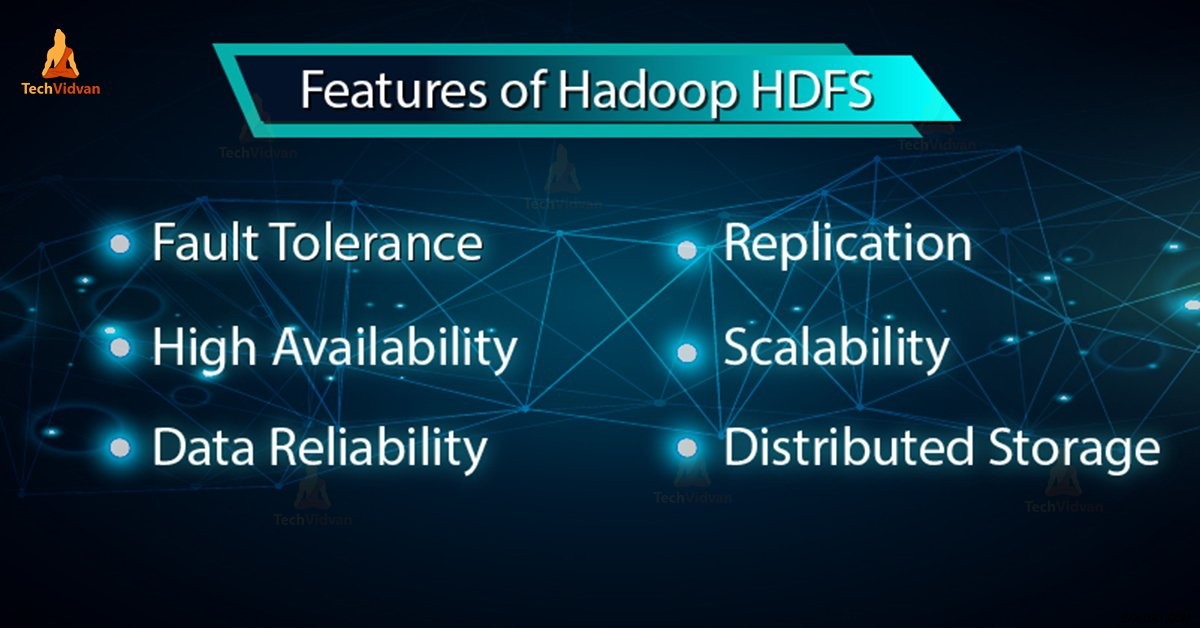

En nuestro blog anterior hemos aprendido Hadoop HDFS en detalle, ahora en este blog, vamos a cubrir las características de HDFS. Hadoop HDFS tiene características como tolerancia a fallas, replicación, confiabilidad, alta disponibilidad, almacenamiento distribuido, escalabilidad, etc.

Todas estas funciones de HDFS en Hadoop se analizarán en este tutorial de Hadoop HDFS.

Introducción a Hadoop HDFS

Sistema de archivos distribuido Hadoop (HDFS) es el sistema de almacenamiento principal de Hadoop. Almacena archivos muy grandes que se ejecutan en un grupo de hardware básico. HDFS se basa en GFS (Google FileSystem). Almacena datos de forma fiable incluso en caso de fallo del hardware.

HDFS también proporciona acceso de alto rendimiento a la aplicación accediendo en paralelo. Según una predicción para fines de 2017, el 75 % de los datos disponibles en el planeta residirán en HDFS.

6 características importantes de HDFS

Después de estudiar la introducción de Hadoop HDFS, analicemos ahora las funciones más importantes de HDFS.

1. Tolerancia a fallas

La tolerancia a fallas en Hadoop HDFS es la fuerza de trabajo de un sistema en condiciones desfavorables. Es altamente tolerante a fallas. El marco Hadoop divide los datos en bloques. Después de eso, crea múltiples copias de bloques en diferentes máquinas en el clúster.

Entonces, cuando cualquier máquina en el clúster deja de funcionar, un cliente puede acceder fácilmente a sus datos desde la otra máquina que contiene la misma copia de bloques de datos.

2. Alta disponibilidad

Hadoop HDFS es un sistema de archivos de alta disponibilidad. En HDFS, los datos se replican entre los nodos del clúster de Hadoop mediante la creación de una réplica de los bloques en los otros esclavos presentes en el clúster de HDFS. Entonces, cada vez que un usuario quiera acceder a estos datos, puede acceder a sus datos desde los esclavos que contienen sus bloques.

En el momento de situaciones desfavorables como la falla de un nodo, un usuario puede acceder fácilmente a sus datos desde los otros nodos. Porque hay copias duplicadas de bloques en los otros nodos del clúster HDFS.

3. Alta confiabilidad

HDFS proporciona un almacenamiento de datos confiable. Puede almacenar datos en el rango de cientos de petabytes. HDFS almacena datos de manera confiable en un clúster. Divide los datos en bloques. El marco Hadoop almacena estos bloques en los nodos presentes en el clúster HDFS.

HDFS almacena datos de manera confiable mediante la creación de una réplica de todos y cada uno de los bloques presentes en el clúster. Por lo tanto, proporciona facilidad de tolerancia a fallas. Si el nodo en el clúster que contiene datos deja de funcionar, entonces un usuario puede acceder fácilmente a esos datos desde los otros nodos.

HDFS por defecto crea 3 réplicas de cada bloque que contiene datos presentes en los nodos. Por lo tanto, los datos están rápidamente disponibles para los usuarios. Por lo tanto, el usuario no enfrenta el problema de la pérdida de datos. Por lo tanto, HDFS es altamente confiable.

4. Replicación

La replicación de datos es una característica única de HDFS. La replicación resuelve el problema de la pérdida de datos en condiciones desfavorables, como fallas de hardware, bloqueo de nodos, etc. HDFS mantiene el proceso de replicación a intervalos de tiempo regulares.

HDFS también sigue creando réplicas de datos de usuario en diferentes máquinas presentes en el clúster. Entonces, cuando cualquier nodo se cae, el usuario puede acceder a los datos de otras máquinas. Por lo tanto, no hay posibilidad de pérdida de datos de usuario.

5. Escalabilidad

Hadoop HDFS almacena datos en varios nodos del clúster. Por lo tanto, siempre que aumenten los requisitos, puede escalar el clúster. Hay dos mecanismos de escalabilidad disponibles en HDFS:Vertical y Escalabilidad horizontal.

6. Almacenamiento Distribuido

Todas las características de HDFS se logran a través del almacenamiento distribuido y la replicación. HDFS almacena datos de manera distribuida entre los nodos. En Hadoop, los datos se dividen en bloques y se almacenan en los nodos presentes en el clúster HDFS.

Después de eso, HDFS crea la réplica de todos y cada uno de los bloques y los almacena en otros nodos. Cuando una sola máquina en el clúster falla, podemos acceder fácilmente a nuestros datos desde los otros nodos que contienen su réplica.

Conclusión

En conclusión, podemos decir que HDFS es altamente tolerante a fallas. Almacena de manera confiable una gran cantidad de datos a pesar de la falla del hardware. También proporciona alta escalabilidad y alta disponibilidad. Por lo tanto, HDFS potencia la funcionalidad de Hadoop. Si encuentra alguna otra característica de HDFS, compártala con nosotros en la sección de comentarios a continuación.