La transformación digital es un tema candente para todos los mercados e industrias, ya que ofrece valor con tasas de crecimiento explosivas. Considere que el Internet de las cosas (IIOT) de la industria manufacturera se valoró en $ 161 mil millones con una tasa de crecimiento impresionante del 25 %, el mercado de automóviles conectados se valorará en $ 225 mil millones para 2027 con una tasa de crecimiento del 17 %, o que en los primeros tres meses de 2020, los minoristas se dieron cuenta de diez años de penetración de ventas digitales en solo tres meses. Sin embargo, la mayor parte de lo que se escribe tiene que ver con las plataformas tecnológicas habilitadoras (nube o borde o soluciones puntuales como almacenes de datos) o casos de uso que impulsan estos beneficios (análisis predictivos aplicados al mantenimiento preventivo, detección de fraude de instituciones financieras o monitoreo predictivo de la salud). como ejemplos) no los datos subyacentes. El capítulo que falta no trata sobre soluciones puntuales o el viaje de madurez de los casos de uso. El capítulo que falta es sobre los datos, siempre se trata de los datos, y, lo que es más importante, los datos del viaje se entrelazan desde el perímetro hasta el conocimiento de la inteligencia artificial.

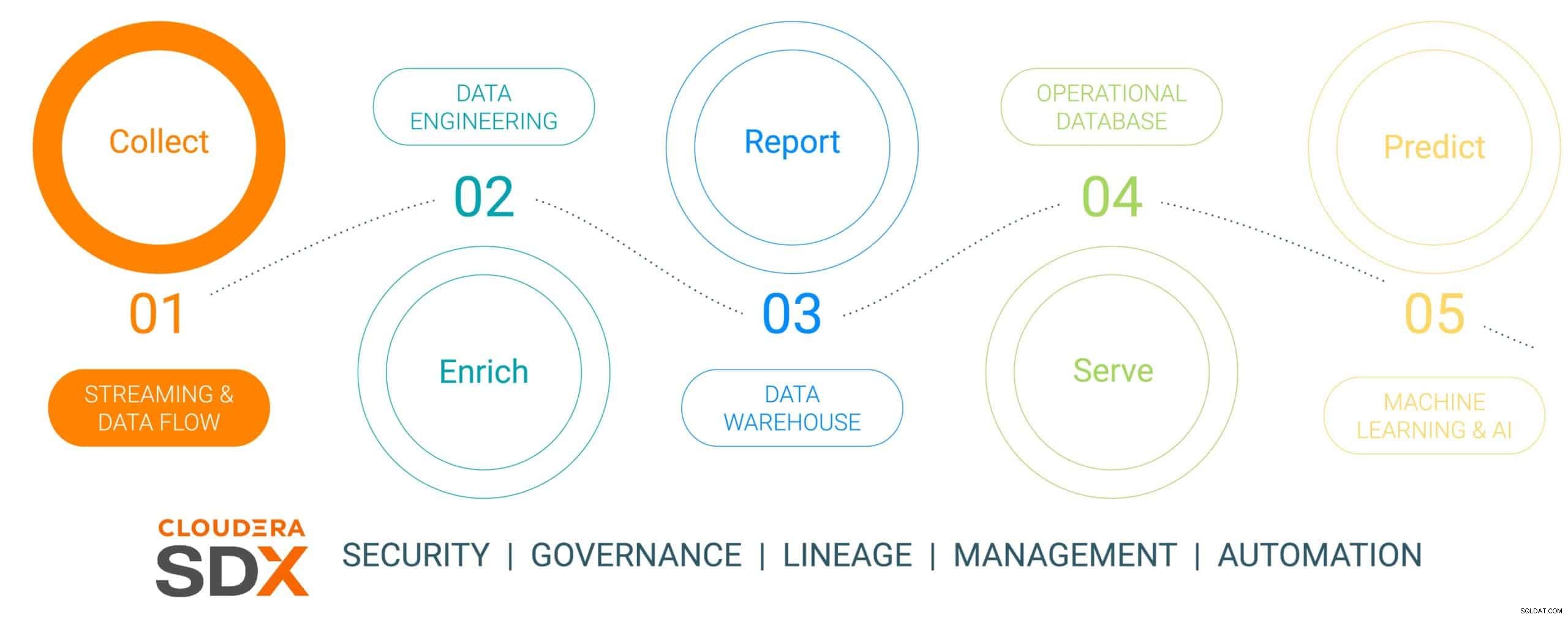

Este es el primero de una serie de blogs de seis partes que describe el viaje de los datos desde el borde hasta la IA y el valor comercial que producen los datos a lo largo del viaje. El viaje de los datos no es lineal, sino que es un ciclo de vida de datos de bucle infinito:se inicia en el perímetro, se entrelaza a través de una plataforma de datos y da como resultado conocimientos imperativos comerciales aplicados a problemas reales críticos para el negocio que dan como resultado nuevas iniciativas basadas en datos. Hemos simplificado este viaje en cinco pasos discretos con un sexto paso común que habla de seguridad y gobierno de datos. Los seis pasos son:

- Recopilación de datos – ingestión de datos y monitoreo en el borde (ya sea el borde sensores industriales o personas en una tienda minorista)

- Enriquecimiento de datos – procesamiento, agregación y administración de canalización de datos para preparar los datos para un mayor refinamiento

- Informes – proporcionar información empresarial empresarial (análisis y previsión de ventas, estudios de mercado, elaboración de presupuestos, por ejemplo)

- Porción: controlar y ejecutar operaciones comerciales esenciales (transacciones en cajeros automáticos, pagos minoristas o supervisión de la producción)

- Análisis predictivo: análisis predictivo basado en inteligencia artificial y aprendizaje automático (detección de fraude, mantenimiento predictivo, optimización de inventario basada en la demanda como ejemplos)

- Seguridad y gobernanza: un conjunto integrado de tecnologías de seguridad, administración y gobierno a lo largo de todo el ciclo de vida de los datos

Fig. 1:El ciclo de vida de los datos empresariales

Para ilustrar el viaje de los datos, hemos elegido un tema de fabricación muy relevante y de mentalidad sostenible:la fabricación de un automóvil eléctrico, elegido porque las operaciones de fabricación suelen ser de naturaleza revolucionaria (alta madurez digital que implementa las herramientas de datos más actualizadas) , en comparación con la "evolutiva de la vieja escuela" (de menor madurez) y que la mayoría de estos automóviles se construyen como plataformas de movilidad conectada, lo que hace que el automóvil sea más que un simple transporte, sino una plataforma para el conocimiento y la comprensión basados en datos. Esta historia mostrará cómo se recopilan, enriquecen, almacenan, entregan y luego utilizan los datos para predecir eventos en el proceso de fabricación del automóvil utilizando Cloudera Data Platform.

Esta historia contará con una empresa de fabricación de vehículos eléctricos simulados llamada (con un nombre muy original) The Electric Car Company (ECC). ECC opera múltiples fábricas de fabricación ubicadas en todo el mundo, está integrada verticalmente y construye sus propios automóviles, así como muchos de los componentes críticos, incluidos motores eléctricos, baterías y piezas auxiliares. Cada fábrica se encarga de fabricar diferentes componentes y el ensamblaje final se lleva a cabo en unas pocas fábricas seleccionadas y estratégicamente ubicadas.

Desafío de recopilación de datos

Administrar la recopilación de todos los datos de todas las fábricas en el proceso de fabricación es una tarea importante que presenta algunos desafíos:

- Dificultad para evaluar el volumen y la variedad de datos de IoT: Muchas fábricas utilizan activos y dispositivos de fabricación modernos y heredados de múltiples proveedores, con varios protocolos y formatos de datos. Aunque los controladores y dispositivos pueden estar conectados a un sistema OT, generalmente no están conectados de manera que puedan compartir fácilmente los datos también con los sistemas de TI. Para permitir la fabricación conectada y los casos de uso de IoT emergentes, ECC necesita una solución que pueda manejar todo tipo de estructuras y esquemas de datos diversos desde el perímetro, normalizar los datos y luego compartirlos con cualquier tipo de consumidor de datos, incluidas las aplicaciones de Big Data.

- Administrar la complejidad de los datos en tiempo real: Para que ECC impulse los casos de uso de análisis predictivo, una plataforma de administración de datos debe permitir el análisis en tiempo real de la transmisión de datos. La plataforma también necesita ingerir, almacenar y procesar de manera efectiva los datos de transmisión en tiempo real o casi en tiempo real para brindar información y acción al instante.

- Liberar datos de silos independientes: Los procesos especializados (plataformas de innovación, QMS, MES, etc.) dentro de la cadena de valor de fabricación recompensan fuentes de datos dispares y plataformas de gestión de datos que se adaptan a soluciones únicas en silos. Estas soluciones de nicho limitan el valor empresarial, considerando solo una fracción de la información que pueden ofrecer los datos entre empresas, mientras dividen el negocio y limitan las oportunidades de colaboración. La plataforma correcta debe tener la capacidad de ingerir, almacenar, administrar, analizar y procesar datos de transmisión desde todos los puntos de la cadena de valor, combinarlos con fuentes de historiadores de datos, ERP, MES y QMS, y aprovecharlos para obtener información procesable. Estos conocimientos generarán paneles, informes y análisis predictivos que impulsarán casos de uso de fabricación de alto valor.

- Equilibrar el borde: Comprender el equilibrio correcto entre el procesamiento de datos en el borde y en la nube es un desafío, y es por eso que se debe considerar todo el ciclo de vida de los datos. Existe una tendencia preocupante en la industria, ya que las empresas optan por centrarse en uno u otro sin darse cuenta de que pueden y deben hacer ambas cosas. La computación en la nube tiene sus beneficios para el análisis a largo plazo y la implementación a gran escala, pero está limitada por el ancho de banda y, a menudo, recopila grandes cantidades de datos y solo utiliza una pequeña parte. El valor del perímetro radica en actuar en el perímetro donde tiene el mayor impacto con latencia cero antes de enviar los datos más valiosos a la nube para un procesamiento adicional de alto rendimiento.

Recopilación de datos mediante Cloudera Data Platform

PASO 1:Recopilación de datos sin procesar

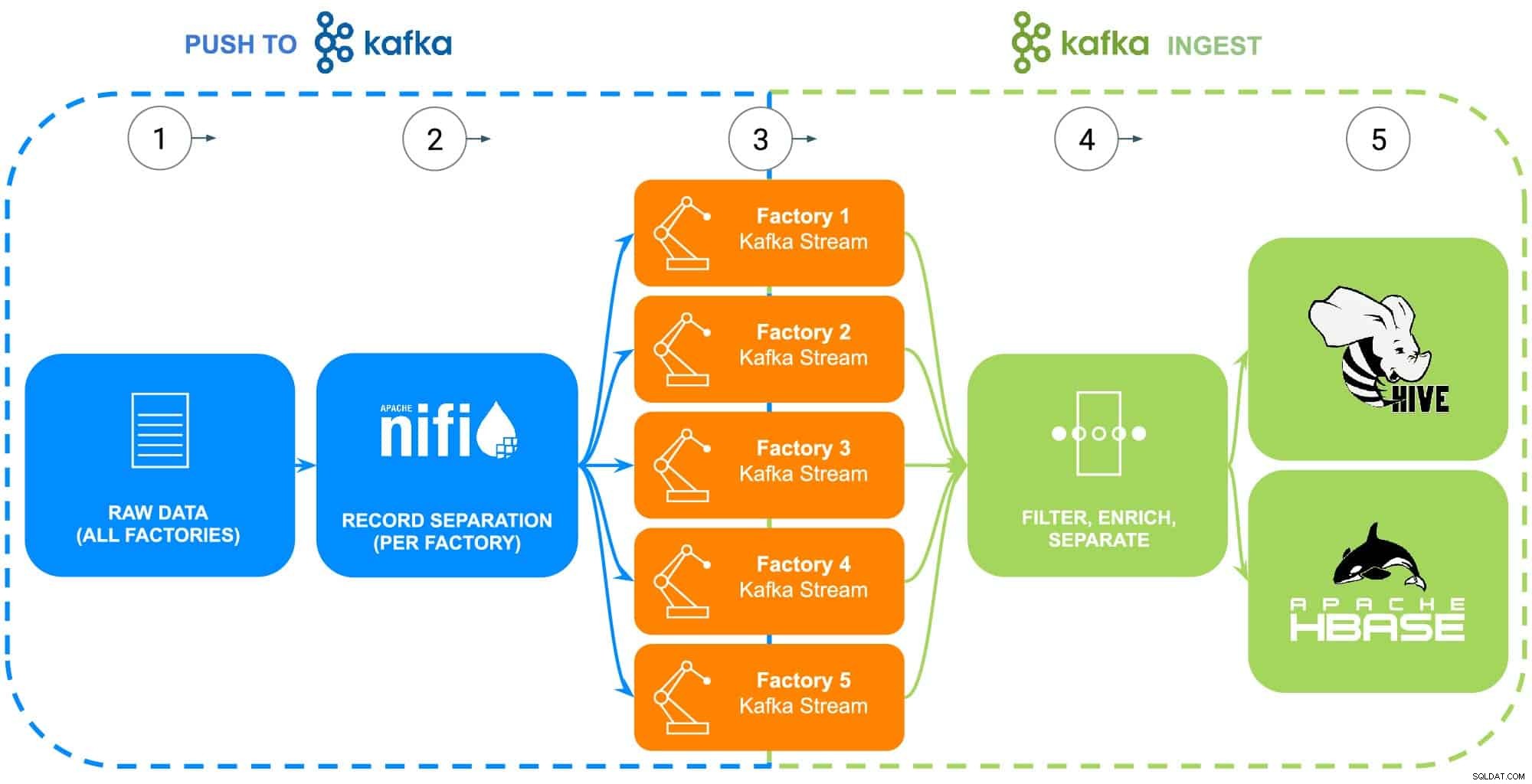

Los datos de la operación de fabricación de ECC abarcan una multitud de fuentes:robots industriales, tanques de proceso de revestimiento de fosfato de cuerpo en blanco (temperatura, concentración o reabastecimiento), telemática de la cadena de suministro o información de la pieza maestra, etc. Para este ejemplo específico, la pieza sin procesar Se recopilaron datos maestros para cada una de las cinco fábricas de ECC en preparación para alimentar a Apache NiFi (ver Fig. 2).

PASO 2:Configurar fuentes de datos para cada fábrica

La recopilación de datos se ilustrará utilizando la experiencia Data Flow de Cloudera (con tecnología de Apache NiFi) para recuperar estos datos sin procesar y dividirlos en flujos de fábrica individuales (administrados por Apache Kafka) para parecerse con mayor precisión a un escenario del mundo real (ver Fig. 2). Para simplificar el ejemplo, se eligieron las siguientes etiquetas de atributos de datos para cada pieza generada por las fábricas:

- ID de fábrica

- ID de máquina

- Marca de tiempo fabricada

- Número de pieza

- Número de serie

Fig. 2:Diagrama de flujo de recopilación de datos.

PASO 3:Supervisar el rendimiento de datos de cada fábrica

Ahora que todos los datos fluyen hacia flujos individuales de Kafka, un arquitecto de datos supervisa el rendimiento de datos de cada fábrica y ajusta los recursos informáticos y de almacenamiento necesarios para asegurarse de que cada fábrica tenga el rendimiento necesario para enviar datos a la plataforma.

PASO 4:capturar datos de secuencias de Apache Kafka

Kafka captura todos los flujos de datos de la fábrica y los recopila en procesadores que filtrarán y enriquecerán para su uso en el control y la ejecución de operaciones comerciales esenciales impulsadas por una base de datos operativa, o para brindar información empresarial empresarial a través de un almacén de datos empresariales o para utilizar en análisis avanzados.

ECC comenzó recientemente la producción de una versión mejorada de su motor eléctrico que solo se produce en Factory 5, estos datos se utilizarán como ilustración de los próximos pasos en el ciclo de vida de los datos

PASO 5:Enviar datos a soluciones de almacenamiento

Dado que los ingenieros de calidad y fabricación de ECC querrán monitorear de cerca la implementación y el uso de campo de este motor, los datos específicos de trazabilidad de fabricación se filtran en una ruta separada y se guardan en su propia tabla en Apache Hive. Esto permitirá a los ingenieros ejecutar consultas ad-hoc en Cloudera Data Warehouse contra los datos más adelante, así como unirlos a otros datos relevantes en el almacén de datos de la empresa, como órdenes de reparación o comentarios de los clientes para producir casos de uso avanzados como garantía, predictivo rutinas de mantenimiento o entrada de desarrollo de productos.

Alternativamente, si se desea controlar y ejecutar operaciones comerciales esenciales, el conjunto de datos completo con la adición de una marca de tiempo procesada se enviará a la base de datos operativa de Cloudera con tecnología Apache HBase. Estos datos servirán como base para que ECC ejecute su plataforma de inventario, lo que requerirá el uso constante de operaciones de lectura/escritura, ya que el inventario se puede agregar y eliminar miles de veces al día. Dado que HBase está diseñado para manejar este tipo de transacciones de datos a gran escala, es la mejor solución para este desafío único.

Conclusión

Esta simple ilustración muestra la importancia de obtener la ingestión correcta de datos, ya que es fundamental para la información proporcionada desde bases de datos operativas, almacenes de datos empresariales o análisis predictivo de aprendizaje automático avanzado. El valor de "hacerlo bien" incluye el uso de datos de cualquier fuente empresarial, rompiendo así los silos de datos, utilizando todos los datos, ya sean de transmisión u orientados por lotes, y la capacidad de enviar esos datos al lugar correcto para producir la perspectiva de flujo descendente deseada.

Usando CDP, los ingenieros de datos de ECC y otros usuarios de la línea de negocios pueden comenzar a usar los datos recopilados para diversas tareas que van desde la gestión de inventario hasta el pronóstico de piezas y el aprendizaje automático. Dado que Cloudera Data Flow promueve la ingesta de datos en tiempo real desde cualquier fuente empresarial, se puede expandir y mantener sin un conocimiento extenso de varios lenguajes de programación y metodologías de recopilación de datos patentadas. Si se encuentran problemas únicos, los ingenieros también pueden crear sus propios procesos para un control verdaderamente detallado.

Busque el próximo blog que profundizará en el enriquecimiento de datos y cómo respalda la historia del ciclo de vida de los datos. Además, esta historia se complementará con demostraciones basadas en datos que muestran el viaje de los datos a través de cada paso del ciclo de vida de los datos.

Más recursos de recopilación de datos

Para ver todo esto en acción, haga clic en los enlaces relacionados a continuación para obtener más información Recopilación de datos:

- Video:si desea ver y escuchar cómo se construyó, vea el video en el enlace.

- Tutoriales:si desea hacer esto a su propio ritmo, vea un tutorial detallado con capturas de pantalla e instrucciones línea por línea sobre cómo configurarlo y ejecutarlo.

- Reunión:si desea hablar directamente con expertos de Cloudera, únase a una reunión virtual para ver una presentación en vivo. Habrá tiempo para preguntas y respuestas directas al final.

- Usuarios:para ver más contenido técnico específico para los usuarios, haga clic en el enlace.