En este Tutorial de Hadoop, discutiremos las 10 mejores características de Hadoop. Si no está familiarizado con Apache Hadoop, puede consultar nuestra Introducción a Hadoop blog para obtener un conocimiento detallado del marco Apache Hadoop.

En este blog, repasaremos las funciones más importantes de Big Data Hadoop, como la tolerancia a fallas de Hadoop, el procesamiento distribuido en Hadoop y la escalabilidad, Fiabilidad, Alta disponibilidad, económico, flexibilidad, localidad de datos en Hadoop.

Introducción a Hadoop

Hadoop es un marco de software de código abierto que admite el almacenamiento distribuido y el procesamiento de una gran cantidad de conjuntos de datos. Es la herramienta de big data más poderosa del mercado debido a sus características. Características como tolerancia a fallas, confiabilidad, alta disponibilidad, etc.

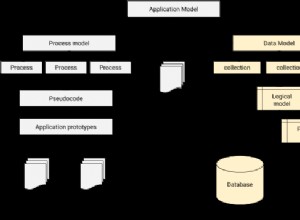

Hadoop proporciona-

- HDFS – La capa de almacenamiento más confiable del mundo

- Reducir mapa – Capa de procesamiento distribuida

- HILO – Capa de gestión de recursos

Características importantes de Big Data Hadoop

Hay tantas características que proporciona Apache Hadoop. Analicemos estas características de Hadoop en detalle.

a. Código abierto

Es un marco de programación de código abierto basado en Java. Código abierto significa que está disponible gratuitamente e incluso podemos cambiar su código fuente según sus requisitos.

b. Tolerancia a fallas

Hadoop controla fallas por el proceso de creación de réplicas. Cuando el cliente almacena un archivo en HDFS, el marco Hadoop divide el archivo en bloques. Luego, el cliente distribuye bloques de datos entre diferentes máquinas presentes en el clúster HDFS.

Y, luego, cree la réplica de cada bloque en otras máquinas presentes en el clúster. HDFS, por defecto, crea 3 copias de un bloque en otras máquinas presentes en el clúster.

Si alguna máquina en el clúster se cae o falla debido a condiciones desfavorables. Entonces también, el usuario puede acceder fácilmente a esos datos desde otras máquinas.

c. Procesamiento Distribuido

Hadoop almacena una gran cantidad de datos de forma distribuida en HDFS. Procese los datos en paralelo en un grupo de nodos.

d. Escalabilidad

Hadoop es una plataforma de código abierto. Esto la convierte en una plataforma extremadamente escalable. Por lo tanto, los nuevos nodos se pueden agregar fácilmente sin ningún tiempo de inactividad. Hadoop proporciona escalabilidad horizontal, por lo que se agrega un nuevo modelo de nodo sobre la marcha al sistema. En Apache hadoop, las aplicaciones se ejecutan en más de miles de nodos.

e. Confiabilidad

Los datos se almacenan de manera confiable en el clúster de máquinas a pesar de la falla de la máquina debido a la replicación de datos. Entonces, si alguno de los nodos falla, también podemos almacenar datos de manera confiable.

f. Alta disponibilidad

Debido a las múltiples copias de datos, los datos están altamente disponibles y accesibles a pesar de la falla del hardware. Por lo tanto, cualquier máquina se cae, los datos se pueden recuperar de la otra ruta. Aprenda la función de alta disponibilidad de Hadoop en detalle.

g. Económico

Hadoop no es muy costoso ya que se ejecuta en el clúster de hardware básico. Como utilizamos hardware básico de bajo costo, no necesitamos gastar una gran cantidad de dinero para escalar su clúster de Hadoop.

yo. Flexibilidad

Hadoop es muy flexible en términos de capacidad para manejar todo tipo de datos. Se trata de estructurados, semiestructurados o no estructurados.

j. Fácil de usar

No es necesario que el cliente se ocupe de la computación distribuida, el marco se encarga de todo. Por lo tanto, es fácil de usar.

k. Localidad de datos

Se refiere a la capacidad de mover el cálculo cerca de donde residen los datos reales en el nodo. En lugar de mover datos a computación. Esto minimiza la congestión de la red y aumenta el rendimiento del sistema. Obtenga más información sobre Localidad de datos.

Conclusión

En conclusión, podemos decir que Hadoop es altamente tolerante a fallas. Almacena de manera confiable una gran cantidad de datos a pesar de la falla del hardware. Proporciona alta escalabilidad y alta disponibilidad.

Hadoop es rentable ya que se ejecuta en un grupo de hardware básico. Hadoop trabaja en la localidad de datos, ya que mover el cálculo es más barato que mover datos. Todas estas características de Big data Hadoop lo hacen poderoso para el procesamiento de Big data.